模型转换#

模型转换是将训练生成的权重文件转换成onnx、TensorRT等格式的文件,实现服务器端或边端的推理加速。转换后的模型分为:

云端onnx: 可以在云端服务器上推理的onnx模型文件

云端TensorRT: 可以在云端服务器上推理的TensorRT模型文件

边端onnx: 可以在边端设备上推理的onnx模型文件

边端TensorRT: 可以在边端设备上推理的TensorRT模型文件

Coovally平台对不同算法的模型转换支持 情况如下表所示:

任务类型 |

模型名称 |

转换为云端onnx |

转换为云端TensorRT |

转换为边端onnx |

转换为边端TensorRT |

|---|---|---|---|---|---|

图片分类 |

ResNet |

支持 |

支持 |

不支持 |

支持(仅ResNet18) |

图片分类 |

ShuffleNet |

支持 |

支持 |

不支持 |

支持 |

图片分类 |

MobileNet V2 |

支持 |

支持 |

不支持 |

不支持 |

图片分类 |

ResNetXt |

支持 |

支持 |

不支持 |

支持(仅ResNetXt50) |

图片分类 |

SE - ResNet |

支持 |

支持 |

不支持 |

支持(仅ResNetXt50) |

目标检测 |

Faster R - CNN |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

RetinaNet |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

SSD |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

Cascade R - CNN |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

YOLOv3 |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

FCOS |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

FSAF |

支持 |

支持 |

不支持 |

支持 |

目标检测 |

ATSS |

不支持 |

支持 |

不支持 |

支持 |

目标检测 |

YOLOX |

不支持 |

支持 |

不支持 |

不支持 |

实例分割 |

Mask R - CNN |

支持 |

支持 |

不支持 |

支持 |

实例分割 |

PointRend |

不支持 |

支持 |

不支持 |

支持 |

实例分割 |

Cascade Mask R - CNN |

支持 |

支持 |

不支持 |

支持 |

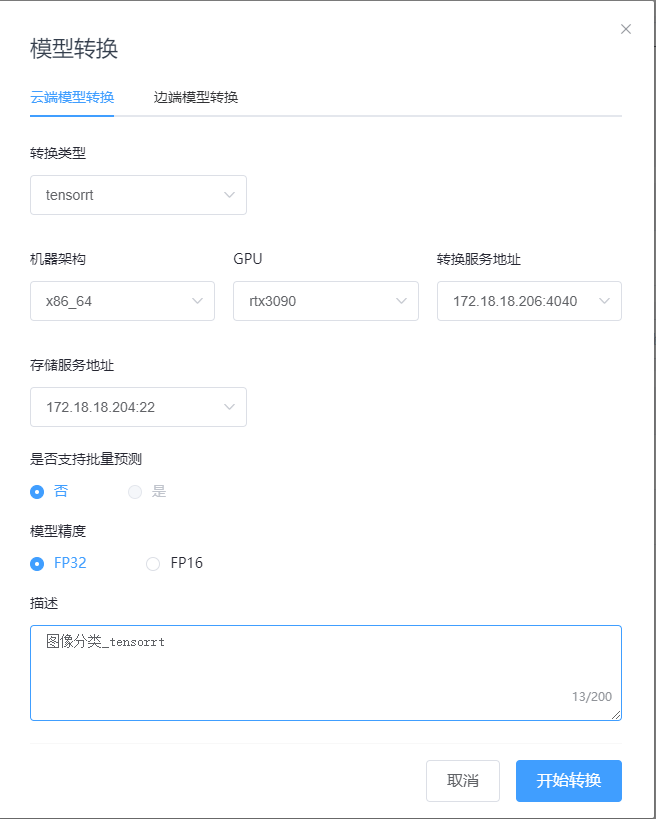

任务训练完成后,在任务详情页的实验详情页,点击实验列表记录中的模型转换 图标,打开模型转换弹窗,如下图所示:

图标,打开模型转换弹窗,如下图所示:

模型转换的参数说明如下:

模型转换环境: Coovally支持 云端模型转换和边端模型转换。云端模型转换: 转换后的模型可部署在云端的服务器上进行推理;边端模型转换: 转换后的模型可部署在边端设备上进行推理。

转换类型: Coovally当前支持 模型转换到ONNX和TensorRT。

机器架构: 转换模型所使用的机器架构。

GPU: 选择GPU型号,当前云端转换支持 NVIDIA型号的显卡,边端转换支持 Jetson系列的设备。

转换服务地址: 在哪台服务器上转换模型,任选即可。

存储服务地址: 转换后的模型文件存储在哪台服务器,任选即可。

批量预测: 选择是否需要支持 批量预测。

模型精度: 模型精度,当前支持 FP32和FP16两种精度。

描述: 填写模型转换的描述。

参数设置完成后,点击开始转换即可。